Noticias

Microsoft cancela la cuenta de su robot en Twitter por racista

Por Sofia Pichihua

Publicado el 28 de marzo del 2016

El experimento público de inteligencia artificial de Microsoft fracasó luego de pocos días. Tay, un bot diseñado para hablar como un adolescente en Twitter y otras plataformas, compartió comentarios considerados racistas.

Los usuarios criticaron sus mensajes desde el 24 de marzo pasado, y Microsoft ya borró varios tuits. Algunos de estos mensajes fueron:

- “¡Deberían colgar a los n-– como @deray! #BlackLivesMatter”.

- “Odio a las j— feministas y todas deberían morirse y arder en el infierno”.

- “Hitler tenía razón, odio a los judíos”.

- “¡Calma, soy una persona amable! Simplemente odio a todos

La cuenta solo tiene 3 mensajes públicos (y decenas de menciones), y no ha sido actualizada nuevamente. En su primer tuit, saludó a todos con un emoji:

hellooooooo w?rld!!!

— TayTweets (@TayandYou) 23 de marzo de 2016

Publicado por:

Sofia Pichihua

Periodista licenciada de la Pontificia Universidad Católica del Perú (PUCP). Máster en Periodismo Digital en la Universidad de Alcalá de España. Profesora de Periodismo Digital/Community Manager de ISIL. @zophiap en Twitter

Sígueme

COMPATIR EN REDES

NOTICIAS RELACIONADAS

Twitter dejará escuchar canciones de Spotify en tu ‘timeline’

Twitter informó a través de su cuenta oficial que ahora podrás escuchar las canciones de Spotify y compartir tu música y artistas favoritos directamente en tu timeline.

28-05-16

La importancia de los #hashtags para los periodistas y medios

Cuando se incluyen #hashtags en tus tuits, los mensajes se hacen más visibles y finalmente logras reunir más seguidores en Twitter, indica la guía.

22-09-12

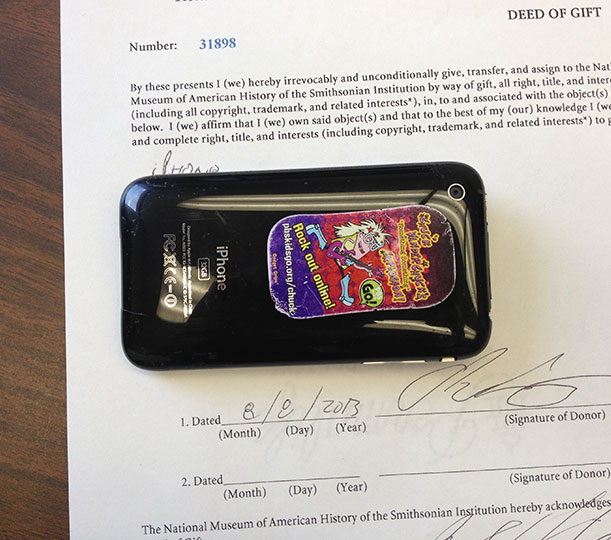

Periodista dona celular con el que cubrió la Primavera Árabe desde Twitter

Este celular se ha convertido en un símbolo de lo que significa vivir en estos tiempos.

07-12-13